Problematika důvěryhodných AI systémů

Jak ukazuje mediální všudypřítomnost nové AI aplikace OpenAI „ChatGPT“, umělá inteligence dosáhla působivé úrovně vyspělosti. Chatbot, vyškolený daty a textem z celého internetu, odpovídá na otázky odpověďmi, které je obtížné odlišit od textu napsaného lidmi. Díky tomu stojí systém umělé inteligence za zvážení pro širokou škálu úkolů ve společnostech, ať už jde o marketingové úkoly, automatizaci toho, jak jsou zpracovávány dotazy zákazníků, nebo generování mediálního obsahu.

Jak ukazuje mediální všudypřítomnost nové AI aplikace OpenAI „ChatGPT“, umělá inteligence dosáhla působivé úrovně vyspělosti. Chatbot, vyškolený daty a textem z celého internetu, odpovídá na otázky odpověďmi, které je obtížné odlišit od textu napsaného lidmi. Díky tomu stojí systém umělé inteligence za zvážení pro širokou škálu úkolů ve společnostech, ať už jde o marketingové úkoly, automatizaci toho, jak jsou zpracovávány dotazy zákazníků, nebo generování mediálního obsahu.

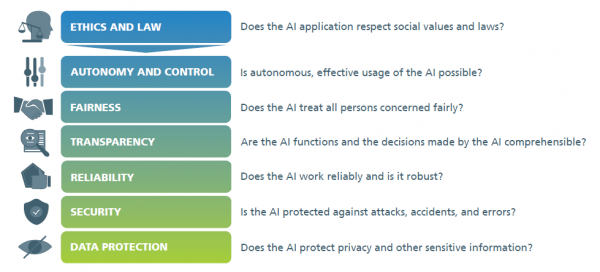

Navrhování důvěryhodných a transparentních systémů umělé inteligence není vůbec jednoduchá záležitost. Kritika na poli umělé inteligence míří mimo jiné na nedostatek transparentnosti, jako jsou zdroje, ze kterých chatbot generuje své odpovědi. Zejména předpovědi jsou závislé na kvalitě vstupních dat. To ukazuje, jak důležité je umět systematicky hodnotit kvalitu aplikací umělé inteligence. To platí zejména v citlivých oblastech aplikací, jako je lékařská diagnostika, řízení lidských zdrojů, finance, aplikace používané orgány činnými v trestním řízení nebo oblasti kritické z hlediska bezpečnosti, kde systémy umělé inteligence musí poskytovat naprosto spolehlivé výsledky. Zákony o umělé inteligenci, jako například evropský návrh regulace systémů umělé inteligence, řadí tyto příklady do kategorie vysoce rizikových a v těchto případech dokonce vyžadují povinné posouzení. Toho lze dosáhnout pomocí nástrojů pro hodnocení AI.

Certifikace aplikací umělé inteligence

Protože aplikace AI často pracují s obzvláště velkými množství dat a používají vysoce komplexní modely, je obtížné v praxi pro uživatele zkontrolovat, zda jsou zajištěny funkce, které mají provádět. Pro tyto účely jsou určeny testovací a certifikační systémy AI aplikace, které by mohly využívat akreditovaní inspektoři. Kromě zajištění technické spolehlivosti je nutné také zkontrolovat odpovědné použití z pohledu etického a právního. Ve výsledku by pak vydaný certifikát z testování měl potvrzovat standard kvality a zákonnou i etickou „nezávadnost“. To umožňuje vývojářům a poskytovatelům služeb umělé inteligence navrhovat aplikace zákonně a eticky přijatelné. Zároveň by to mělo umožňovat i porovnávat vlastnosti a schopnosti AI aplikací od různých poskytovatelů a tedy podporovat otevřenou soutěž v oblasti umělé inteligence.

Nástroje pro testování AI

Na veletrhu Hannover Messe 2023 Fraunhoferův institut pro inteligentní analýzu a informační systémy IAIS představil různé testovací nástroje pro hodnocení a systematické zkoumání slabin v AI systémech. To vše pro zamezení negativních důsledků a k ochraně proti rizikům AI.

Na veletrhu Hannover Messe 2023 Fraunhoferův institut pro inteligentní analýzu a informační systémy IAIS představil různé testovací nástroje pro hodnocení a systematické zkoumání slabin v AI systémech. To vše pro zamezení negativních důsledků a k ochraně proti rizikům AI.

Fraunhoferův institut IAIS se sídlem v Sankt Augustinu nedaleko Bonnu vyvíjí testovací nástroje, které zkoumají a hodnotí aplikace AI z hlediska jejich spolehlivosti, spravedlnosti, robustnosti, transparentnosti nebo ochrany dat. Maximilian Poretschkin, vedoucí oddělení bezpečné umělé inteligence a certifikace umělé inteligence ve Fraunhofer IAIS, společně se svým týmem vyvíjí hodnotící nástroje a metody, které zkoumají a hodnotí aplikace AI. Nástroje lze modulárně kombinovat a jsou zabudovány do softwarového rámce.

Nástroj ScrutinAI

Nástroj ScrutinAI se používá k detekci chyb v AI modelech nebo tréninkových datech a umožňuje analyzovat příčiny, například model AI pro detekci abnormalit a onemocnění na CT snímcích. Zde umožňuje testovacím ústavům systematicky hledat slabá místa v neuronových sítích a testovat tak kvalitu aplikací AI. Otázkou je, zda jsou všechny typy anomálií detekovány stejně dobře nebo některé lépe a jiné hůře. ScrutinAI analýza pak pomáhá posoudit, zda je aplikace AI vhodná pro zamýšlený kontext použití.

Metoda uncertAInty

Metoda „uncertAInty“ integrovaná do frameworku vybavuje neuronové sítě hodnocením kvality v závislosti na situaci, s níž hodnotí svou vlastní jistotu s ohledem na provedenou předpověď. Zejména v případě vysoce automatizovaných rozhodnutí je důležité umět posoudit, jak jistá je AI svým výsledkem. Například konkrétně autonomní vozidlo musí být schopno spolehlivě rozpoznat předměty a osoby ve svém okolí, aby na ně mohlo vhodně reagovat. Posouzení nejistoty pomáhá měřit, zda je rozhodnutí systému důvěryhodné, nebo zda je třeba aktivovat určité záložní mechanismy. AI tak tímto způsobem může zpochybňovat svá vlastní rozhodnutí.

Nástroj Benchmarking

Nakonec je tu nástroj „Benchmarking“. Ten se používá ke zkoumání, který model umělé inteligence je pro konkrétní úkol nejvhodnější. Dnes již začíná existovat přebytek nových aplikací umělé inteligence, které mohou společnosti integrovat do svých procesů. Benchmarking jim pak má pomáhat učinit správnou volbu.

Nástroj Benchmarking má funkční schopnost, mimo jiné, měřit spravedlivost trénovacích datových sad. To je zásadní v HR průmyslu, například pokud jde o aplikace AI, které pomáhají s výběrem nových zaměstnanců. V těchto situacích je třeba aplikaci AI trénovat pomocí vyvážených a statisticky reprezentativních souborů dat, aby se zabránilo znevýhodňování skupin lidí a aby byly zajištěny rovné příležitosti. Tým z Fraunhofer IAIS na veletrhu Hannover Messe 2023 použil "Benchmarking" interaktivní demonstrátor z lékařské oblasti, aby ukázal, jak lze systematicky hodnotit kvalitu aplikace AI pomocí hodnotících nástrojů.

Závěr

Oblast testování systémů umělé inteligence určitě zažije v blízké budoucnosti velký "boom" s tím, jak se začne AI postupně prakticky a masivně zakomponovávat do běžného života a zejména do průmyslové výroby a služeb. Protože AI systémům nejsou jejich chování exaktně naprogramována jako u klasických naprogramovaných logických sekvenčních systémů, nelze pro ně využít stejné metody testování softwaru využívané doposud a je tedy nutné vyvinout postupy a systémy zcela nové. Tato oblast vývoje sice asi nebude plnit stránky populárních časopisů, bude ale jistě neméně důležitá. Proto mám v plánu se jí v dalších článcích dále zaobírat.

Na úplný závěr pak jedna prognóza: Nakonec asi pravděpodobně nastane situace, že systémy umělé inteligence budou testovat jiné systémy umělé inteligence, podobně jako v lidském světě jedna skupina lidí hlídá druhou skupinu lidí. Tedy asi něco jako AI pracovník a AI inspektor, kde oba bude řídit AI manažer...

Odkazy:

- Článek "Ethics tutoring for AI ": https://www.hannovermesse.de/en/news/news-articles/ethics-tutoring-for-ai

- Webové stránky Fraunhoferova institutu IAIS: https://www.iais.fraunhofer.de/en/research/artificial-intelligence.html

- Dokument „TRUSTWORTHY USE OF ARTIFICIAL INTELLIGENCE“ na webu Fraunhoferova institutu sekce IAIS: https://www.iais.fraunhofer.de/content/dam/iais/KINRW/Whitepaper_Trustworthy_AI.pdf

- Webové stránky Fraunhoferova institutu IAIS o hodnocení a certifikace systémů umělé inteligence: https://www.iais.fraunhofer.de/en/research/artificial-intelligence/ai-assessment-catalog.html#Receive-our-AI-assessment-catalog-free-of-charge